In de digitale wereld van vandaag is het – een set van botinstructies – een essentieel hulpmiddel voor elke website die zichtbaar en gemakkelijk vindbaar wil zijn voor het beoogde publiek. De kern van deze missie is zoekmachineoptimalisatie (SEO), een krachtige strategie om het bereik van je site te vergroten. Terwijl veel mensen zich richten op inhoud en zoekwoorden, speelt een vaak over het hoofd geziene element een cruciale rol in het vormgeven van SEO-succes: het-bestand. ogenschijnlijk eenvoudige tekstbestand kan aanzienlijk invloed hebben op hoe zoekmachine-crawlers met je website omgaan.

Dit Een goed samengesteld bestand zorgt ervoor dat zoekmachines de juiste secties van je site prioriteren, wat de prestaties en zichtbaarheid vergroot. Voor DigitalErena.nl is een geoptimaliseerd bestand van cruciaal belang om ervoor te zorgen dat zoekmachines worden geleid naar de belangrijkste secties van de site. In deze uitgebreide gids verkennen we alles wat je moet weten over het en hoe je deze kunt beheersen om je website te optimaliseren.

Wat is Robots.txt en Waarom Is Het Belangrijk?

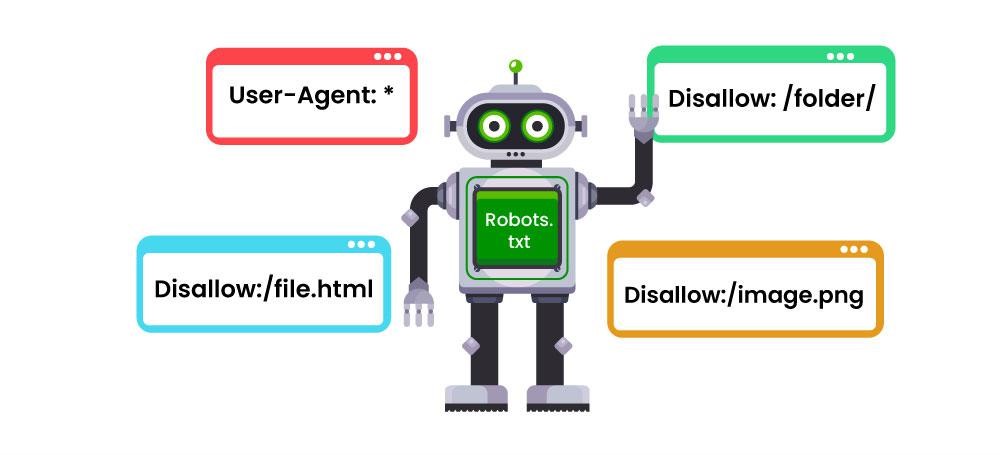

Het robots.txt-bestand is een platte tekstbestand dat zich in de hoofdmap van je website bevindt. Het biedt instructies aan web crawlers (bots die door zoekmachines worden gebruikt) over hoe ze je site moeten navigeren en ermee moeten interageren. Het is in wezen de manier waarop je website zegt: “Dit is wat je wel en niet mag openen.”

Robots.txt is van cruciaal belang voor:

- SEO-optimalisatie: Geeft crawlers aanwijzingen om zich te concentreren op je belangrijkste inhoud, wat het rankingpotentieel van je site vergroot door SEO-optimalisatie.

- Prestatiebeheer: Vermindert serverbelasting door te voorkomen dat onnodige of zware pagina’s worden gecrawld.

- Privacycontrole: Houdt gevoelige gebieden, zoals beheerderspanelen of privébestanden, buiten het bereik van zoekmachines.

Echter, het verkeerd beheren van je robots.txt-bestand kan leiden tot aanzienlijke problemen, zoals het onbedoeld blokkeren van belangrijke pagina’s om geïndexeerd te worden. Daarom is het essentieel om te begrijpen hoe je het effectief beheert.

Voordelen van een Goed Geoptimaliseerd Robots.txt-bestand

- Crawlen stroomlijnen: Zoekmachines helpen bij het prioriteren van waardevolle pagina’s terwijl irrelevante secties worden overgeslagen.

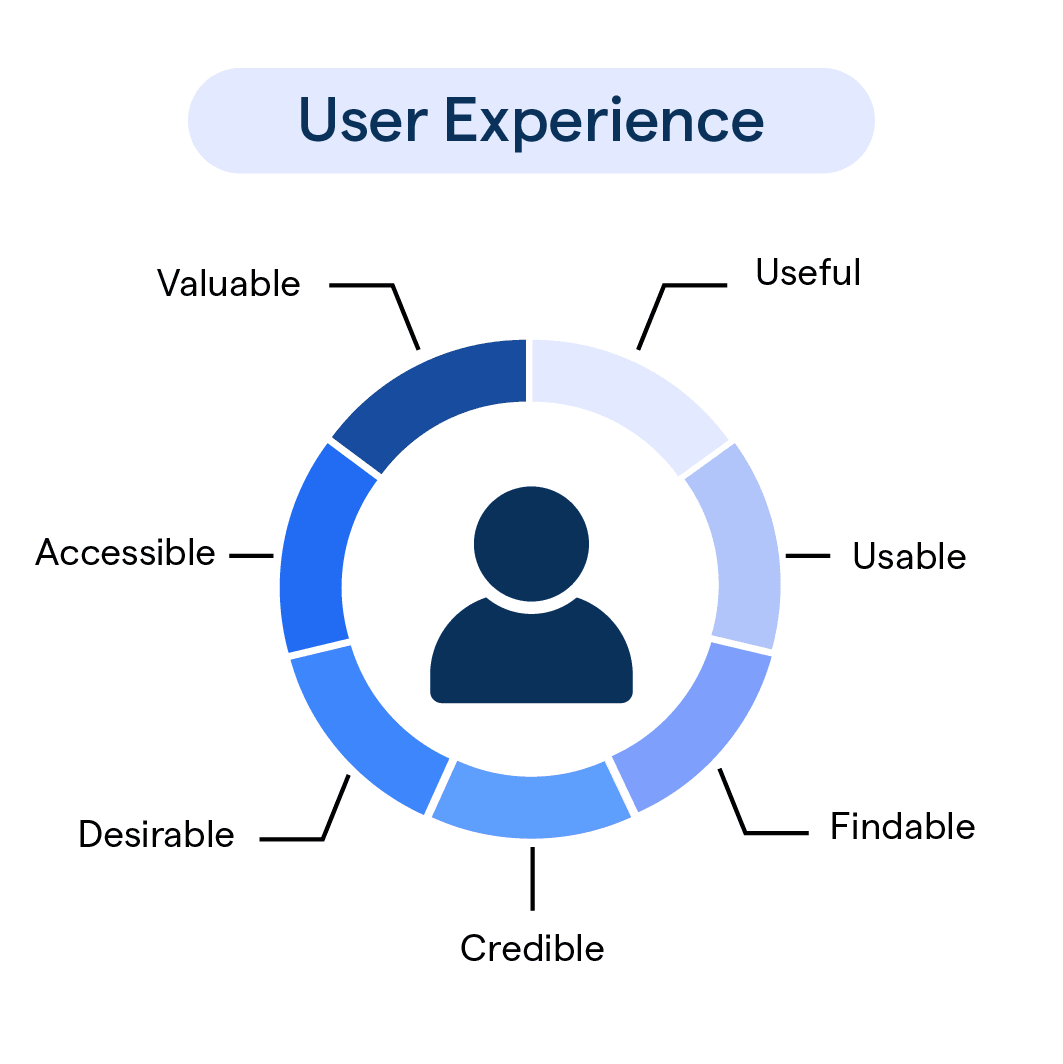

- Gebruikservaring verbeteren: Zorgen dat gebruikers de meest relevante en goed gestructureerde inhoud vinden wanneer ze zoeken, wat ook de klantenservice ten goede komt.

- Veiligheid verbeteren: Voorkomen dat web crawlers gevoelige gebieden zoals inlogpagina’s of stagingomgevingen indexeren.

- Snelheid verhogen: Serverprestaties optimaliseren door onnodige crawlersactiviteiten te verminderen.

Hoe Werkt Robots.txt?

In wezen werkt robots.txt door regels te communiceren naar web crawlers. Wanneer een bot je website bezoekt, zoekt hij eerst naar het robots.txt-bestand om te bepalen welke pagina’s of mappen het kan openen. Het bestand bestaat uit regels die specificeren welke bots toegang hebben tot bepaalde delen van je site.

Pro Tips voor Robots.txt Meesterschap

- Zorg altijd voor een Robots.txt-bestand

Niet alle websites bevatten een robots.txt-bestand, maar het hebben ervan is cruciaal voor effectief crawlersbeheer. Zelfs als je geen specifieke gebieden hoeft te blokkeren, voorkomt het verstrekken van een duidelijk bestand verwarring en zorgt het ervoor dat crawlers je site efficiënt kunnen navigeren. Plaats het bestand in de hoofdmap van je website zodat het gemakkelijk toegankelijk is.

- Zorg altijd voor een Robots.txt-bestand

- Blokkeer toegang tot irrelevante pagina’s

Bepaalde delen van je website hoeven niet gecrawld of geïndexeerd te worden. Bijvoorbeeld:- Beheergebieden: Bescherm backend-secties zoals inlogpagina’s of dashboards.

- Dupliceerbare inhoud: Vermijd het indexeren van pagina’s die je SEO-inspanningen kunnen verwateren, zoals zoekresultatenpagina’s of sessiegebonden URL’s.

- Stagingomgevingen: Voorkom dat crawlers toegang krijgen tot onvolledige of testversies van je site.

- Blokkeer toegang tot irrelevante pagina’s

Door deze secties te blokkeren, kun je de aandacht van de crawlers richten op de delen die het belangrijkst zijn.

- Houd belangrijke pagina’s toegankelijk Hoewel het blokkeren van irrelevante pagina’s essentieel is, is het ook belangrijk om ervoor te zorgen dat je meest kritieke inhoud toegankelijk blijft. Onbedoelde beperkingen op belangrijke secties, zoals productlijstingen of blogberichten, kunnen schadelijk zijn voor je SEO-prestaties en je online winkel. Controleer regelmatig je robots.txt-bestand om te verifiëren dat belangrijke gebieden openstaan voor crawlers.

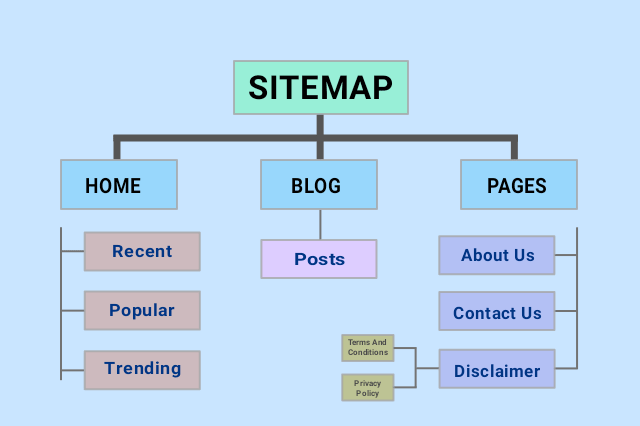

- Voeg je Sitemap toe Het toevoegen van een sitemaplink in je robots.txt-bestand is een best practice. Een sitemap dient als een gids voor crawlers en helpt hen alle essentiële pagina’s op je website te ontdekken en indexeren. Deze eenvoudige toevoeging zorgt voor efficiënt crawlen en verbetert de vindbaarheid van je inhoud.

- Pas regels aan voor specifieke bots Verschillende zoekmachines gebruiken verschillende bots om websites te crawlen. Bijvoorbeeld, Google gebruikt Googlebot, terwijl Bing Bingbot gebruikt. Door je robots.txt-regels aan te passen voor specifieke bots, kun je optimaliseren hoe verschillende zoekmachines met je site omgaan. Je zou bijvoorbeeld een crawlvertraging kunnen instellen voor de ene bot, terwijl je de andere bot onbeperkte toegang toestaat.

- Voorkom het blokkeren van kritieke bronnen Moderne websites vertrouwen op middelen zoals CSS en JavaScript voor de juiste functionaliteit en rendering. Het blokkeren van deze bronnen in je robots.txt-bestand kan het voor crawlers moeilijk maken om de structuur van je site te begrijpen, wat resulteert in indexeringsproblemen. Zorg er altijd voor dat essentiële middelen toegankelijk blijven.

- Beheer crawlfrequentie voor drukke websites Als je website veel verkeer ontvangt, kan overmatige crawling door bots de server belasten. Gebruik de crawl-delay-instructie om te beperken hoe vaak een bot pagina’s aanvraagt. Dit helpt de siteprestaties te behouden zonder de crawlbaarheid in gevaar te brengen.

- Test en werk regelmatig bij Een kleine fout in je robots.txt-bestand kan leiden tot aanzienlijke problemen, zoals het blokkeren van je hele site. Gebruik tools zoals Google’s Robots.txt Tester of Bing Webmaster Tools om je bestand te valideren en fouten te voorkomen. Werk je robots.txt-bestand ook bij wanneer je nieuwe secties toevoegt of structurele wijzigingen aan je website aanbrengt.

Veelvoorkomende Fouten om te Vermijden

- Het blokkeren van de hele site: Een eenvoudige misconfiguratie, zoals het blokkeren van alle mappen, kan je site onzichtbaar maken voor zoekmachines.

- Vergeten updates: Het verwaarlozen van updates van je robots.txt-bestand na wijzigingen aan de site kan leiden tot gemiste kansen of crawl-fouten.

- Onjuiste toepassing van wildcards: Het verkeerd gebruiken van wildcards kan onbedoelde resultaten veroorzaken, zoals het blokkeren van cruciale pagina’s. Test je regels om ervoor te zorgen dat ze zoals bedoeld werken.

Geavanceerde Strategieën voor Robots.txt

Voor degenen die verder willen gaan dan de basis, overweeg dan deze geavanceerde technieken:

- Dynamische Robots.txt-bestanden: Gebruik server-side scripting om een aangepast robots.txt-bestand te genereren dat zich aanpast aan de structuur van je site.

- Beveiligingsverbeteringen: Hoewel robots.txt crawlers kan verhinderen om toegang te krijgen tot gevoelige gebieden, is het geen beveiligingsmaatregel. Bescherm privébestanden met de juiste authenticatie en serverconfiguraties.

- Tijdelijke blokkades: Als je werkt aan een nieuw project of een functie test, kun je robots.txt gebruiken om tijdelijk toegang te blokkeren, maar vergeet niet de beperkingen te verwijderen zodra het live is.

Conclusie

Een goed geoptimaliseerd robots.txt-bestand is een krachtig hulpmiddel voor websitebeheer. Door zoekmachine crawlers effectief te begeleiden, kun je ervoor zorgen dat de meest waardevolle inhoud van je site prioriteit krijgt, terwijl irrelevante of gevoelige gebieden buiten het bereik blijven. Met de juiste aanpak verbeter je niet alleen de SEO van je site, maar ook de algehele prestaties en bruikbaarheid.

Neem de tijd om je robots.txt-bestand vandaag nog te beheersen. Door dit te doen, creëer je een website die niet alleen crawler-vriendelijk is, maar ook klaar is voor langdurig succes in het competitieve digitale landschap.